De traditionele wijze van het toegankelijk maken van beeldmateriaal is het door mensen laten beschrijven van de beelden. Dit is een arbeidsintensieve klus, zou het niet anders kunnen? In dit artikel beschrijf ik twee alternatieve werkwijzen om beeldmateriaal toegankelijk te krijgen.

Het beschrijven van een foto vergt tijd en kennis, het is werk dat is weggelegd voor specialisten in combinatie van lokale kennisdragers. Het bereiken van een grotere groep mensen die kunnen helpen kan bijvoorbeeld via Flickr of Wikipedia. Bij Flickr The Commons kunnen organisaties foto’s plaatsen en kunnen gebruikers van Flickr daar commentaar bij zetten (maar het systeem heeft natuurlijk een andere focus). Wikipedia gebruikt rechtenvrije foto’s die beschikbaar zijn op WikiMedia. Doordat afbeeldingen gebruikt worden in artikelen kom je via een omweg tot een beschrijving van foto’s. Nadeel van deze werkwijze is dat de set foto’s waarschijnlijk niet gestructureerd en eenduidig worden beschreven. Ook zit er nog “handwerk” in het vergaren van de beschrijvingen in het eigen collectiebeheersysteem.

Metadata Games

Een eerste alternatief dat ik wil belichten is het open source crowdsourcing game platform Metadata Games. Dit platform biedt diverse spelvormen aan, voor web en mobiel, die vooral zijn gericht op het beschrijven van afbeeldingen, video en audio.

Eén van de spellen is “Guess What!”. In dit spel zijn er twee spelers. Speler 1 ziet een afbeelding en geeft hier een korte beschrijving van. Speler 2 ziet 9 afbeeldingen en moet afgaande op de beschrijving de juiste foto kiezen. Nadat de foto is geraden draaien de rollen om.

Deze gamification is een leuke laagdrempelige manier om een set foto’s te laten beschrijven. Hierbij biet het platform ook een “beheerachterkant” die het uploaden van fotosets en het exporteren van de resultaten mogelijk maakt.

Machine learning en neuraal netwerken

Een tweede alternatief verminderd de input van de mens in grote mate: het laat de computer de foto’s beschrijven! Dit is geen toekomstmuziek. Gebruikers van Google Photo kunnen in hun eigen collectie (die veelal geen beschrijving hebben behalve wat EXIF data die wellicht datum/tijd/breedtegraad/lengtegraad bevatten) eenvoudig zoeken naar “strandfoto’s met het gezin”, het zoekresultaat is veelal goed te noemen. We komen hiermee op het terrein van machine learning en neurale netwerken.

Deze technologie ontwikkelt zich snel. Even zelf een neuraal netwerk trainen voor het beschrijven van een foto collectie behoort – met enige technische kennis – dan ook tot de mogelijkheden. Een kleine proof-of-concept, op basis van een fotoset van het Regionaal Archief Tilburg (beschikbaar gesteld onder een Creative Commons BY-NC-SA licentie), een open-source neuraal netwerk en een Engelstalige basis trainingsset, leert dat dit alternatief het onderzoeken waard is.

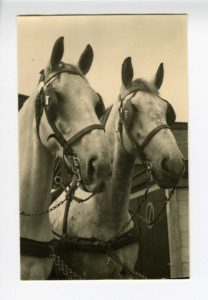

a couple of horses standing next to each other

Via http://lab.coret.org/neural/ kun je het resultaat zien. Sommige beschrijvingen zijn best aardig. Besef je dat een computer deze beschrijvingen heeft samengesteld!

De beschrijvingen zitten er ook nog wel eens naast: een strand wordt aangezien voor sneeuw, mannen en vrouwen worden niet echt onderscheiden, er worden ten onrechte frisbees en kloktorens genoemd en er worden er moderne voorwerpen als mobiele telefoon en laptop herkend in de historische foto’s.

Maar bij de soms wat hilarische teksten moet je je bedenken dat het neurale netwerk gebruikt maakt van bepaalde “kennis”, een set van beschreven foto’s die als input heeft gediend. Ik ben benieuwd wat de kwaliteit zal zijn als er een Nederlandstalige historische fotoset met beschrijvingen als trainingsset wordt gebruikt!

Toegankelijker door steekwoorden

Via beide bovenbeschreven alternatieven zal sommige informatie niet boven water komen, denk aan de datum en namen van personen, gebouwen, voertuigen en plaatsen. Wellicht moeten de alternatieven dan ook vooral ingezet worden om de foto’s te voorzien van steekwoorden (tags). Met deze steekwoorden worden beeldcollecties, die beschrijving en steekwoorden ontberen, al een stuk toegankelijker.

Nu nog een innovatieve opdracht- of werkgever vinden waar ik bovenstaande alternatieven verder kan uitwerken…